Priceless

[ML] 혼자 공부하는 머신러닝+딥러닝 Ch.4 본문

Ch.4 다양한 분류 알고리즘

4-1. 로지스틱 회귀

로지스틱 회귀

로지스틱 회귀: 선형 방정식을 학습하는 분류 모델

시그모이드 함수(로지스틱 함수)를 통해 클래스 확률을 출력

로지스틱 회귀는 계수의 제곱을 규제(L2 규제)

소프트맥스: 지수 함수를 모두 계산해 더한 후 그 합을 각 지수 함수에 나눈 것

출력 결과의 합이 1이다

4-2. 확률적 경사 하강법

점진적인 학습

경사 하강법: 목적 함수를 낮추기 위해 조금씩 내려오는 방식

조금씩 내려와야 가장 낮은 목적 함수를 찾을 수 있다

크게 내려오면 목적 함수가 오히려 올라갈 수 있다

확률적 경사 하강법: 경사 하강법에서 전체 샘플을 사용하지 않고

하나의 샘플을 훈련 세트에서 랜덤하게 골라 가장 확률이 높은 답을 구하는 방법

점진적 학습 또는 온라인 학습이라고 부른다

에포크: 훈련 세트를 한 번 모두 사용하는 과정

경사 하강법은 수십, 수백 번 이상 에포크를 수행한다

손실 함수(목적 함수): 어떤 문제에서 머신 러닝 알고리즘이 나타나는 오류를 측정하는 기준

손실 함수가 낮을수록 성능이 좋은 머신 러닝이다

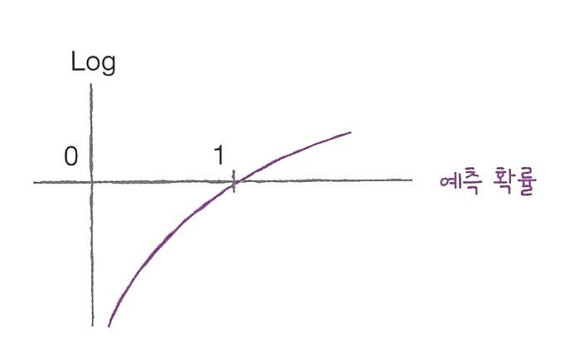

로지스틱 손실 함수:

타깃 = 1일 때

-log(예측 확률)

타깃 = 0일 때

-log(1-예측 확률)

SGD Classifier

에포크를 높이면 정확도가 향상될 수 있다

첨부 코드 참조

에포크와 과대/과소적합

에포크가 적으면 훈련 세트가 덜 학습되어 과소 적합이 발생한다

에포크가 너무 많으면 훈련 세트에 너무 잘 맞아 과대 적합이 발생한다

과대 적합이 나타나기 전에 학습을 조기 종료 해야한다

'AI > ML' 카테고리의 다른 글

| [ML]Image Classification과 Pytorch 실습 (1) | 2024.01.07 |

|---|---|

| [ML] 혼자 공부하는 머신러닝+딥러닝 Ch.6 (0) | 2023.08.29 |

| [ML] 혼자 공부하는 머신러닝+딥러닝 Ch.5 (0) | 2023.08.21 |

| [ML] 혼자 공부하는 머신러닝+딥러닝 Ch.3 (0) | 2023.08.08 |

| [ML] 혼자 공부하는 머신러닝+딥러닝 Ch.1 & 2 (0) | 2023.08.01 |